La statistica bivariata misura la relazione tra due diverse variabili, rappresentate da due gruppi di punteggi.

Quello che di solito interessa sapere è se c'è una covariazione, ovvero se al variare di una variabile varia anche l'altra (variabile indipendente e dipendente).

Lo scopo della dell'analisi bivariata è dunque quello di analizzare se

esiste una relazione tra due variabili e se questa è statisticamente

significativa, ovvero non sia dovuta al caso.

L'analisi bivariata prende in esame solo 2 variabili alla volta, non

tendo conto delle possibili influenze delle altre variabili.

Per le scale nominali/ordinali dicotomiche si usa il test del Chi quadrato, mentre per le scale a intervalli o a rapporti viene utilizzato il test r di Pearson.

Chi quadrato

Con il test del Chi quadrato si vuole verificare la relazione tra la variabile indipendente e quella indipendente, ecco la procedura teorica completa:

- Il campione deve essere casuale ed indipendente, ovvero deve essere estratto in maniera completamente casuale ed appartenere solo ad una delle 2 variabili

- Le frequenze osservate (f0) devono essere diverse da zero

- Si ricavano le frequenze teoriche (ft) che devono essere maggiori di 5

- Le variabili devono essere su scale categoriali (nominale e/o ordinale)

- Si calcola il Chi quadrato

- Si formulano le ipotesi sperimentali, quella nulla H0 indica l'assenza di relazione e pone il chi quadrato uguale a zero, quella alternativa H1 indica la presenza di relazione con chi quadrato diverso da zero

- Si fissa il livello di significatività α

- Si identifica nella tavola del chi quadrato i valori critici in relazione ai gradi di libertà calcolati in relazione al numero di righe e colonne: (r-1)*(c-1)

- Si applica il test statistico del chi quadrato

- Si prende una decisione se:

chi quadrato calcolato < chi quadrato critico -> p>α ACCETTO H0

chi quadrato calcolato >= chi quadrato critico -> p<=α RIFIUTO H0

| Promossi | Bocciati | ||

| Italiani | 60 | 30 | |

| Visigoti | 10 | 90 | |

Si vuole verificare la relazione tra italianità e promozione.

Ricavo dunque i valori marginali di riga e di colonna:

| Promossi | Bocciati | ||

| Italiani | 60 | 30 | 90 |

| Visigoti | 10 | 90 | 100 |

| 70 | 120 | 190 |

Mi calcolo la frequenza teoria delle persone italiane promosse, moltiplicando il numero totale degli italiani (90) per il numero totale dei promossi (70) diviso per il numero totale dei campioni in esame (190):

ft=90*70/190=33.2

Si calcolano quindi anche le altre frequenze teoriche (di tutte le celle):

| Promossi | Bocciati | ||

| Italiani | 33.2 | 56.8 | 90 |

| Visigoti | 36.8 | 63.2 | 100 |

| 70 | 120 | 190 |

Adesso è possibile calcolare il valore del Chi quadrato:

X2=((60-33.2)2/33.2)+((30-56.8)2/56.8)+((10-36.8)2/36.8)+((90-63.2)2/63.2)=65.15

Il valore di chi quadro ottenuto è maggiore di zero e quindi sta a significare che esiste una relazione tra le variabili nazionalità e successo (promosso/bocciato).

Tuttavia occorre verificare che questa relazione non sia dovuta al caso.

La relazione di dipendenza trovata nel campione, sarà presente anche nella popolazione?

Per scoprirlo si procede con la verifica dell'ipotesi:

H0: X2=0 (Ipotesi nulla: assenza di relazione tra variabili)

H1: X2!=0 (Ipotesi alternativa: esistenza di relazione tra variabili)

Le frequenze teoriche calcolate per il chi quadrato sono le frequenze attese nel caso non ci sia associazione tra variabili, sono quindi le frequenze dell'ipotesi nulla vera.

Per misurare la probabilità del verificarsi dell'ipotesi nulla, va ricavato il valore critico dalla tabella del test chi quadrato, ma per far ciò abbiamo bisogno di fissare il livello di significatività α che in questo caso porremo uguale a .001, e calcolare i gradi di libertà.

I gradi di libertà si calcolano moltiplicando il numero di righe meno 1 per il numero di colonne meno 1 della nostrata tabella, ovvero:

gdl=(2-1)*(2-1)=1

In generale: il numero dei gradi di un sistema è dato dal numero dei valori che sono liberi di variare. Nelle tabelle 2x2 i gradi di libertà sono 1, dato che i valori marginali sono fissi e solo una cella può variare.

Guardando nella tabella dei valori critici per il test chi quadrato si trova il chi quadrato critico:

X2c=10.827

Essendo:

X2>X2c -> p<=α

Si rifiuta l'ipotesi nulla H0 e si accetta quindi quella alternativa H1, ossia esiste una relazione tra le due variabili in esame.

Il test chi quadrato ha però alcune limitazioni:

Si fa riferimento ad una distribuzione di probabilità di tipo continuo, quando invece il valore calcolato sul campione è di tipo discreto.

Per ovviare a questo problema si può far uso della correzione di continuità di Yates:

Un altro limite è dato dalla possibile presenza di celle con frequenze teoriche inferiori a 5, e a questo si può ovviare cumulando in categorie di variabili, quando però ha senso farlo.

Se il campione è molto elevato occorre non basarsi solo sul test di significatività ma prendere in esame le percentuali, inoltre si può ottenere un valore di chi quadrato elevato solo per la presenza di un valore anomalo inatteso, e questo può falsare tutto, quindi occorre sempre prendere in esame i valori della tabella.

Il coefficiente di Pearson

Per misurare la correlazione tra variabili si usa il coefficiente di correlazione o coeffiente di Pearson che indica la forza della relazione (detta lineare) tra le variabili.

I tipi di relazioni possono essere:

Relazione positiva quando i valori alti di una variabile tendono a presentarsi con i valori alti dell'altra variabile e i valori bassi di una variabile si presentano con i valori bassi dell'altra.

Relazione negativa quando i valori alti di una variabile tendono a presentarsi con i valori bassi dell'altra e i valori bassi di una variabile si presentano con i valori alti dell'altra.

Quando la correlazione è positiva il coefficiente che la esprime avrà coefficiente positivo, e viceversa.

Per mostrare la correlazione graficamente si costruisce un diagramma di dispersione dove in ascisse si mettono i valori della variabile indipendente, mentre in ordinata quelli della variabile dipendente.

Unendo i punti trovati, se esisterà correlazione verrà una retta che va dal basso verso l'alto in caso di relazione positiva, e dal basso verso l'alto in caso di negativa.

Tanto i punti del diagramma sono in prossimità della retta tracciata, tanto più la correlazione risulta elevata.

La forza della relazione è indicata dalla grandezza del valore e non dal segno, e un coefficiente di ±1corrisponde alla correlazione perfetta.

Ad esempio un coefficiente di ±.8 indica una relazione più elevata di uno di ±.5.

Il segno invece, indica la direzione della relazione.

Quando non esiste una relazione la misura della correlazione è uguale a zero (nulla).

Si può avere una correlazione uguale a zero anche quando tra le nostre variabili è presente una relazione di tipo non lineare.

Il modo classico per calcolare pearson è il seguente:

I valori z di X e Y sono ottenuti dalla standardizzazione delle variabili e ciò consente di superare i limiti e le difficoltà quando definiamo le relazioni in termini di varianza e covarianza.

La covarianza (se dovesse servire), si calcola così:

Con la covarianza cmq, non possiamo confrontare i valori ottenuti con 2 coppie di variabili, in quanto possono differire per unità di misura, mentre il coefficiente r, per le caratteristiche della standardizzazione, non risiente delle unità di misura, permettendo così il confronto tra variabili misurate in modi diversi e rilevati su campioni diversi.

Il coefficiente di correlazione corrisponde alla covarianza di variabili standardizzate.

Nel caso non si voglia standardizzare esiste una formula più rapida per calcolare il coefficiente di pearson (è riportata sotto).

Proprietà del coefficiente di pearson:

- Varia da -1 a +1

- Se c'è una correlazione positiva perfetta tra le variabili il valore di r è +1

- Se c'è una correlazione negativa perfetta tra le variabili il valore di r è -1

- Se c'è una correlazione positiva forte tra le variabili il valore di r è vicino a +1

- Se c'è una correlazione negativa forte tra le variabili il valore di r è vicino a -1

- Se c'è una correlazione molto bassa, il valore di r è vicino a 0.

- Il campione deve essere casuale ed indipendente

- Tra le variabili X e Y deve esserci una relazione lineare

- Ciascuna variabile di X e Y deve distribuirsi normalmente nella popolazione

- La distribuzione bivariata data da X e Y deve essere normale

- Le varianze di X e Y nella popolazione devono essere omogene

- Formulare l'ipotesi nulla H0 ponendo r=0, ovvero assenza di relazione

- Formulare l'ipotesi alternativa H1 ponendo r!=0, ovvero presenza di relazione

- Stabilire il livello di signifatività α

- Calcolare i gradi di libertà: gdl=n-2

- Calcolare la statistica con r:

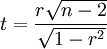

- Se il campione ha un'ampiezza inferiore a 30, il valore calcolato r si trasforma in t:

- Guardare nella tabella del r critico o del t critico

- Prendere una decisione se:

r calcolato < r critico -> p>α ACCETTO H0

r calcolato >= r critico -> p<=α RIFIUTO H0

oppure se l'ampiezza del campione era < 30:

t calcolato < t critico -> p>α ACCETTO H0

t calcolato >= t critico -> p<=α RIFIUTO H0

Si tratta di un coefficiente di correlazione lineare, quindi se tra le variabili c'è una relazione non lineare, otterremo il coefficiente vicino allo zero, come se le variabili fossero indipendenti.

Inoltre r risulta sensibile ai valori elevati nella distribuzione delle variabili.

Quando abbiamo una distribuzione con range alto, abbiamo una correlazione elevata rispetto a quando viene presa in considerazione solo una porzione di valori.

Quando lavoriamo con campioni grandi, il valore di r può diventare significativo anche quando è molto basso, e quindi il risultato ottenuto indica che è stata rifiutata l'ipotesi nulla, ma non fornisce indicazioni sulla grandezza della relazione dimostrata e in questi casi occorre accompagnare r con altri coefficienti per poter interpretare correttamente la relazione.

Regressione

Una variabile è rilevante nel fare le previsioni sull'altra quando tra le due esiste una correlazione, e tanto più questa è forte, e tanto più la previsione risulta accurata.

Assumendo con X la variabile indipendente (in ascissa) e con Y la variabile dipendente (in ordinata), la variabile X viene anche detta predittore, mentre la Y predetta.

Per poter fare una previsione occorre trovare un solo valore di Y in corrispondenza ad un singolo valore di X, e per far questo occorre trovare la retta di regressione.

L'equazione di regressione è invece l'equazione di questa retta da trovare:

Y=a+bX

Il valore b è detto coefficiente di regressione ed indica l'inclinazione (pendenza) della retta, e stabilisce se il valore predetto Y aumenta o diminuisci al variare di X.

E una volta ottenuto b si può ricavare anche a, l'intercetta della retta sull'asse Y:

a=My-bMy

Anche con queste formule, esistono alcune semplificazioni per evitare di dover calcolare gli scarti della media:

e

Per rappresentare graficamente la retta ottenuta, occorre individuare due valori di Y in corrispondenza di due valori di X, e ciò si può fare sostituendo a 2 equazioni di regressione, i rispettivi valori di x e di a e b ricavati, trovando Ý.

La retta ottenuta ci consente di prevedere dei valori della variabile Y anche quando i valori della variabile X non fanno parte dei valori presenti nel campione osservato.

Il valore predetto corrisponde al valore medio del gruppo osservato, tuttavia esiste un grado di errore nella predizione, e risulta utile calcolarlo, semplicemente facendo Y-Ý.

L'errore totale si calcola così:

Questo è l'errore di previsione e tanto più è piccolo e tanto più la previsione risulta accurata.

Quando questo valore è uguale a zero, non esiste errore nella previsione, ma questo è un caso praticamente impossibile e lo scopo del ricercatore è quello di cercare di ridurre al minimo questo errore.

Con minimi quadranti si intende la somma al quadrato degli scarti tra il valore osservato e il valore stimato.

Questo valore risulta minimo quando i valori predetti sono sulla retta di regressione, nella quale si ottiene un errore più basso e quindi una previsione più accurata.

La differenza tra il valore stimato e la media (Ý-My) costituisce una misura di accuratezza.

Lo scarto di ciascun valore osservato dalla media viene scomposto in due componenti:

lo scarto dal valore osservato dal valore predetto dalla retta di regressione (Y-Ý) che corrisponde all'errore, e lo scarto dal valore dal valore predetto dalla retta di regressione dalla media (Ý-My).

Si ha così una parte predetta dalla media e una parte attribuibile all'errore.

Per ottenere una misura complessiva di accuratezza, si usa la seguente formula:

Questo è il coefficiente di determinazione ed indica la proporzione di variabilità nella variabile predetta Y spiegata dalla variabile predittore X.

Se ad esempio otteniamo un coefficiente di determinazione uguale a .75, potremmo dire che il 75% della variazione di Y è dovuta alla variazione di X, e solo il 25% non è spiegato da X.

La parte di variabilità non spiegata può dipendere da un errore di misurazione e di campionamento, ma soprattutto dalla presenza di altre variabili diverse da X.

Correlazione con Spearman

Si usa quando si hanno 2 variabili di tipo ordinale, o una ordinale ed una metrica con n<30, tra le quali si pensa possa esistere una relazioni.

Per poter confrontare le due variabili, occorrerà trasformare la variabile metrica in ordinale (e non viceversa), trasformando ciascun valore in ranghi.

Per trasformare una variabile in un rango ordinale occorre assegnare al più grande il valore uno, al secondo 2, al terzo 3, e così via, assegnando ai valori uguali il rango medio, che sarebbe la somma del rango in cui ci si trova più il successivo diviso 2, fino ad arrivare al numero massimo corrispondente all'altra scala ordinale, ad esempio:

X: 1-2-3-4

Y: 6-3-7-2

RanghiY: 2-3-1-4

Una volta ottenuti i ranghi di Y si calcola D che è la differenza del rango di X-Y e poi si calcola D quadro, per poter poi calcolarci il coefficiente di spearman:

Il coefficiente di spearman ha le stesse caratteristiche del coefficiente di pearson e quindi va da -1 a 1, indicando massima relazione positiva tra variabili se risulta 1, relazione negativa (le variabili sono inversamente proporzionali) se risulta -1, e poca relazione per i valori intorno a zero.

Piaciuto l'articolo? Lascia un commento!

EmoticonEmoticon