Che cos'è l'attendibilità?

In statistica, l'attendibilità si riferisce al grado di accuratezza e di precisione di una procedura di misurazione.

Un test si definisce attendibile/affidabile/fedele quando i punteggi

ottenuti da un gruppo di soggetti sono coerenti, stabili nel tempo e

costanti dopo molte somministrazioni e in assenza di evidenti

cambiamenti come le variazioni psicologiche e fisiche degli individui o

dell'ambiente.

Il coefficiente di affidabilità esprime dunque il grado di fiducia che è lecito riporre in un test.

L'attendibilità di un test esprime la misura in cui le differenze tra i

punteggi di un gruppo di soggetti sottoposti allo stesso test in tempi

diversi o in versioni equivalenti dello stesso stest, possono essere

attribuite a errori casuali di misurazione o al cambiamento dei soggetti

nelle caratteristiche misurate.

L'attendibilità permette quindi di stimare quale proporzione della

variazione totale dei punteggi, sia varianza vera e quale invece è

dovuta ad un errore:

X=V+E

Dove X è il punteggio ottenuto nel test, V è il punteggio vero e E è

l'errore (di conseguenza l'errore si ricava con la formula E=X-V.

Fonti d'errore

Si distingue in errori sistematici ed errori non sistematici o casuali,

questi ultimi possono riguardare la persona testata, la situazione, il

contenuto del test, e vengono detti casuali perchè sono imprevedibili.

Maggiore è l'errore casuale del test e minore è la sua attendibilità, tuttavia la dimensione dell'errore può essere misurata, e nel caso dei gruppi di soggetti si può usare il calcolo del coefficiente di attendibilità, mentre nel caso di soggetti singoli si rileva l'errore standard di misurazione.

Una sorgente d'errore può essere costituita dallo strumento, quindi la selezione degli item è cruciale per l'accuratezza della misurazione.

Anche la somministrazione va tenuta d'occhio, in quanto anche

fattori come l'illuminazione, la temperatura, il rumore ed altri fattori

oggettivi possono contribuire al generarsi dell'errore, bisogna inoltre

tener conto delle condizioni soggettive, come l'ansia e lo stato di

salute.

Inoltre, grazie allo scoring computerizzato sono stati eliminati gli errori di misura dovuti alle differenze tra valutatori.

Errore di misurazione ed affidabilità

Gli assunti della teoria classica della misurazione sono:

- l'errore di misurazione agisce sotto forma di influenza casuale.

- la media degli errori di misurazione è uguale a zero.

- i punteggi reali e gli errori non sono tra loro in correlazione.

- gli errori di misurazione in test diversi non sono tra loro in correlazione.

Il coefficiente di affidabilità rxx è il rapporto tra la varianza del punteggio reale e la varianza totale dei punteggi del test: rxx=Vv/Vx

o anche: rxx=Vv/(Vv+Ve).

La correlazione

Il grado di attendibilità di un test indica il livello di correlazione esistente tra 2 distribuzioni di punteggi ottenuti dagli stessi soggetti nello stesso test.

Il coefficiente di Pearson viene usato per calcolare la correlazione:

Dove Σxy è la sommatoria del prodotto degli scarti di ogni punteggio della variabile x dalla rispettiva media e di quelli della y, al denominatore invece c'è il la radice quadrata del prodotto delle sommatorie dei rispettivi scarti dalla media al quadrato.

Una formula più facilmente calcolabile della correlazione è la seguente:

Dove: XA è il punteggio dei diversi soggetti nella variabile A, XB nella variabile B.

Il coefficiente di Pearson può variare da +1 a -1.

Esistono anche altri coefficienti:

- Rho di Spearman: si usa quando la dimensione del campione è piccola (minore di 30 coppie di misurazioni) e quando le 2 serie di misure sono di tipo ordinale.

- r biseriale rb: si usa quando 2 variabili sono continue in natura ma una delle 2 è stata dicotomizzata, inoltre, la distribuzione della variabile continua deve essere unimodale e simmetrica, mentre quella dicotomizzata deve essere normale.

- Correlazione punto-biseriale rpbi: si usa quando una variabile è continua e l'altra è vera, e non arbitraria, dicotomia, questo coefficiente è appropriato se la dicotomia è ragionevolmente discontinua, inoltre questo coefficiente ha il vantaggio rispetto al biseriale normale di poter esser usato senza la distribuzione della variabile dicotomica sia normale.

- Correlazione tetracorica rt: si usa quando le 2 variabili da correlare sono state arbitrariamente ridotte ad una dicotomia, e si usa solo con grandi campioni.

- Coefficiente phi: si usa quando le variabili costituiscono vere dicotomie.

Il coefficiente di correlazione riflette la proporzione di varianza nei punteggi osservati che va attribuita alla varianza dei punteggi reali.

Il test-retest consiste nel somministrare 2 volte allo stesso gruppo di soggetti lo stesso test, e controllare la correlazione, per poter così valutare l'attendibilità di un test.

Esistono 2 tipi di metodi per il calcolo dell'attendibilità: metodi che richiedono 2 somministrazioni di un test, e metodi che si basano su una sola somministrazione.

L'attendibilità serve per capire quanta probabilità c'è che i risultati di un test siano replicabili o si avvicinano all'accuratezza desiderata.

Metodi che richiedono 2 applicazioni

Un punteggio considerato buono per l'attendibilità non deve essere inferiore .80.

La procedura del test re-test è l'ideale per le misure di quelle caratteristiche considerate stabili nel tempo (come i tratti della personalità) e non vanno bene per quei fattori suscettibili a variazioni (come l'umore e l'ansia).

Anche il tempo trascorso tra una somministrazione ed un'altra deve essere considerato, se è troppo breve i soggetti potrebbero ricordare le risposte, se troppo lungo i soggetti potrebbero esser cambiati interiormente, in generale il tempo massimo è 6 mesi, tempo che diminuisce nel caso dei bambini.

Nel caso di test che presuppongono ragionamenti e calcoli i test re-test potrebbero non essere considerati dei buoni metodi di valutazione, perchè la gente potrebbe apprendere come risolvere i problemi e quindi dare risultati diversi alla seconda somministrazione.

Per risolvere questo problema si usano le forme parallele, che sono 2 versioni diverse dello stesso test, che però risultano simili di contenuto e modalità di risposta.

I passaggi per questo tipo di test sono: somministrazione di una versione, somministrazione dell'altra versione allo stesso gruppo di soggetti, correlazione tra i punteggi ottenuti nelle 2 versioni.

I vantaggi di questo test inoltre sono che si possono somministrare a breve distanza di tempo, mentre gli svantaggi sono che alcuni soggetti potrebbero trovare più facili alcune versioni di altre, inoltre questi test sono molto costosi.

Metodi basati su una sola somministrazione

Esistono diverse procedure per procedere con una sola somministrazione, una di queste consiste nel dividere in 2 parti gli item del test e nel correlarne i relativi punteggi (affidabilità split-half), un altro metodo invece consiste nel considerare ogni item del test come un test formato da un singolo item in modo che il test totale possa essere considerato un insieme di test paralleli, e ciò consente di calcolare la correlazione tra i punteggi dei diversi item e quindi la coerenza interna del test, in modo da capire se tutti gli item del test tendono a misurare lo stesso costrutto psicologico.

Il calcolo del coefficiente di affidabilità split-half prevede 3 passaggi: divisione del test in 2 parti, calcolo del coefficiente di Pearson, correlazione dell'affidabilità con la formula di Spearman-Brown.

La divisione del test di solito viene fatta casualmente, anche se il metodo più usato consiste nel dividere il test in item pari e dispari.

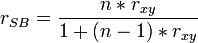

La formula per calcolare l'attendibilità come omogeneità interna è la seguente:

Dove: rxy è il coefficiente di affidabilità del test originale calcolato con Pearson, n è il numero che corrisponde a quanto è stato allungato o accorciato il test, e si ottiene dividendo il numero di item della nuova versione per il numero della versione originale, e nel caso dello split-half n=2.

Se invece si vuole ottenere il numero di volte che un test deve essere allungato si può usare la seguente formula:

Dove: rnXX è il coefficiente di fedeltà che si vuole ottenere, rxx è il coefficiente di fedeltà del test originario.

Quando il livello di affidabilità è abbastanza alto, è necessario un considerevole aumento della lunghezza del test per poter ottenere un modesto aumento nella affidabilità.

Altri metodi per la valutazione della coerenza interna

Per coerenza interna si intende il grado di correlazione di tutti gli item di una scala.

Un test può essere considerato omogeneo se gli item che lo compongono misurano un singolo tratto o fattore, mentre è eterogeneo se è composto da item che misurano più di un fattore, quindi più un test è omogeneo e più è maggiore la sua coerenza interna.

I test omogenei sono più interpretabili ma non sono adatti per misurare variabili psicologiche complesse, nei test eterogenei i soggetti con stesso punteggio potrebbero cmq avere abilità diverse.

Per poter misurare caratteristiche complesse come l'intelligenza, con i test omogenei bisogna somministrarne diverse serie.

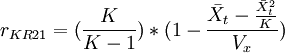

La formula di Kuder-Richardson KR20 viene applicata ai test con item omogenei è adatta a valutare la coerenza interna di test formati da item dicotomici, ed ha la seguente formula:

Dove: K indica il numero degli item del test, Vx è la varianza dei punteggi dell'intero test, Σ(p*q) è la sommatoria del prodotto per ogni item del test della proporzione dei soggetti che hanno dato risposte corrette (p) e di quelli con risposte sbagliate (q).

Quando si pensa che gli item dello stesso abbiano più o meno lo stesso grado di difficoltà si può usare la KR21:

Dove: p- è la media dei p ogni item, q- idem per i q, e questa formula può esser semplificata nel seguente modo:

Dove X-t è la media dei punteggi totali del test.

Il coefficiente alpha di Cronbach è la media di tutti i possibili coefficienti split-half corretti con la formula sperman-brown, e può essere usato con test che prevedono risposte con più di 2 alternative:

Dove: ΣVi è la sommatoria della varianza dei punteggi ottenuti in ogni item, Vx è la varianza dei punteggi totali.

Questo coefficiente può assumere valori che vanno da .00 a +1.00, ed è un indice del grado in cui un test misura un singolo fattore, quindi i test eterogenei produrranno alpha bassi, i test omogenei alpha alti.

Misure di affidabilità tra correttori

Per calcolare l'affidabilità tra scores si applica una semplice procedura: 2 correttori assegnano punteggi ad un campione di protocolli indipendentemente l'uno dall'altro e poi si correlano questi punteggi, accoppiandoli, e più è alto il coefficiente di correlazione ottenuto e minore è la varianza d'errore.

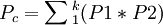

Un altro approccio per la stima dell'affidabilità è il coefficiente Kappa:

Dove: P0 è la proporzione di giudizi concordanti tra i giudici, Pc è la proporzione di giudizi casualmente concordanti, e si possono avere valori da -1 a 1 (-1 si ha con applicazioni insensate).

Per calcolare il Pc: per ogni giudice si deve calcolare la proporzione dei giudizi concordanti rispetto ad ogni categoria comportamentale (P1 e P2), si moltiplica la proporzione del giudice 1 con quella del giudice 2, si sommano i prodotti ottenuti:

Uso ed interpretazione dei coefficienti di attendibilità

Per verificare un test se è attendibile anche a distanza di tempo si usa la procedura test re-test, mentre per verificare un test somministrato una sola volta, si valuta il livello di coerenza interna.

Per i test che misurano una sola caratteristica psicologica, si usa il coefficiente alpha, mentre per test multifattoriali questo coefficiente può essere usato per misurare la coerenza interna degli item raggruppati nei singoli fattori o sottotest.

I metodi split-half funzionano bene per quegli strumenti che sono costruiti con item ordinati gerarchicamente secondo il loro livello di difficoltà.

Alcune caratteristiche specifiche dei test:

- Omogeneità o eterogeneità degli item di un test: se un test possiede item omogenei, dovrebbe presentare un alto coefficiente di coerenza interna.

- Caratteristiche psicologiche dinamiche o statiche: se si pensa che la caratteristica psicologica possa variare per motivi situazionali in momenti diversi, allora il test re-test potrebbe non essere efficace, mentre il miglior risultato si può ottenere attraverso la misura della coerenza interna degli item, viceversa, il test re-test e le forme parallele sono i metodi più adeguati.

- Gamma ristretta dei soggetti: nel valutare il coefficiente di affidabilità riportato in un manuale, deve essere tenuta in considerazione la gamma di abilità del gruppo testato.

- Test di velocità: la maggior parte dei test contengono elementi di velocità e di potenza, e la procedura più adatta per valutare l'affidabilità di test di velocità è quella del re-test, o forme parallele, o sullo spit-half se le 2 metà del test sono somministrate in 2 momenti diversi, correggendo il coefficiente di fedeltà tramite la formula di Spearman-Brown.

- Lunghezza del test: più è lungo il test è più è affidabile.

I test criteriali si diversificano da quelli normativi perchè forniscono un'indicazione del livello di prestazione di un soggetto, rispetto ad un obiettivo o criterio, e gli item di questi test son del tipo "raggiunto" o "non raggiunto".

La formula del coefficiente di affidabilità del test criteriale è la seguente:

Dove: n è il numero dei soggetti che non raggiungono il criterio in entrambe le somministrazioni, b è il numero dei soggetti che lo raggiungono in entrambe, f è il numero dei soggetti che raggiungono il criterio solo nella prima, s solo nella seconda, v è il valore più basso tra quelli raggiunti da f e da s.

Interpretazione del coefficiente di affidabilità

Secondo diversi studiosi, il coefficiente di affidabilità dovrebbe essere di almeno .90 quando un test viene usato per prendere decisioni sugli individui.

In generale, un'affidabilità piccola consente di prendere decisioni su gruppi numericamente consistenti, mentre per le decisioni sui singoli occorre un coefficiente più elevato.

L'errore standard di misura è la deviazione standard di una serie di punteggi che si otterrebbe sottoponendo più volte un soggetto ad uno stesso test.

La formula dell'errore standard di misurazione è:

Dove: Ds è la deviazione standard del test, rXX è il coefficiente di affidabilità del test.

L'errore standard può essere usato come la deviazione standard, la quale permette di stabilire la percentuale dei punteggi che con maggiore probabilità cadrà all'interno dei limiti definiti per un soggetto.

Quindi il 68% dei punteggi ci si aspetta che cada tra + o - 1DSmis, il 95% tra + o - 2DSmis, il 99.7% tra + o - 3DSmis.

La percentuale dei punteggi compresi nei vari intervalli viene definita livello di confidenza, e convenzionalmente si usa un intervallo di fiducia del 95%, in modo da avere solo 1 possibilità su 20 di sbagliare.

L'errore standard di misura è un modo per esprimere l'affidabilità di un test, minore è l'errore e maggiore è affidabile il test, ed è il metodo più usato per interpretare il punteggio ottenuto da un singolo individuo.

L'errore standard della differenza tra 2 punteggi è una misura statistica che permette di stabilire quanto grandi devono essere le differenze tra 2 punteggi perchè possano essere considerate statisticamente significative e non puramente casuali.

Questo errore consente di sapere: se esistono differenze tra i punteggi ottenuti dallo stesso soggetto in due test diversi, se esistono differenze nei punteggi ottenuti nello stesso test da 2 soggetti diversi, se esistono differenze nei punteggi ottenuti da due diversi soggetti in differenti test.

La formula per il calcolo di questo errore è la seguente:

Dove: rxx è il coefficiente di affidabilità del primo test e ryy è quello del secondo.

Questo errore è maggiore rispetto all'errore standard di misura dei singoli punteggi, perchè il primo dipende dagli errori di entrambi i punteggi.

La generalizzabilità dei punteggi di un test

La teoria della generalizzabilità di Cronbach sostiene che è possibile generalizzare da un insieme di punteggi ad un altro gruppo di plausibili misure.

Questa teoria induce a pensare all'attendibilità come ad una caratteristica dell'uso dei punteggi del test, piuttosto che ad una caratteristica dei punteggi in se stessi, e riconosce inoltre che si possono prendere spesso decisioni più affidabili circa le prestazioni relative degli individui, piuttosto che nella valutazione del loro livello assoluto in un certo attributo.

Quindi lo stesso insieme di punteggi può avere differenti gradi di attendibilità a seconda dell'uso che si vuole fare di essi.

La teoria della generalizzabilità identifica sia le fonti sistematiche che quelle casuali di incoerenza che possono contribuire a generare errori.

Piaciuto l'articolo? Lascia un commento!

EmoticonEmoticon